|

Читайте также: |

x = sim(net,P);

x1 = cat(1,x{:});

figure(2), plot(time,x1,'b:+', time,p,'r-o'),grid on

legend('вихід', 'вхід')

gensim(net) % виклик Simulink структури НМ

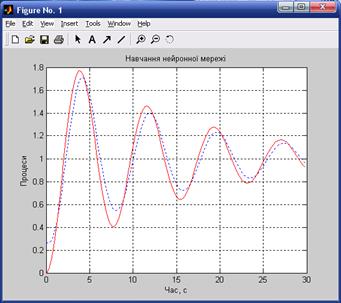

В результаті проведення даного сценарію можуть бути отримані наступні результати рис.6.4.

Рисунок 6.4 – Часові діаграми навчання та роботи НМ

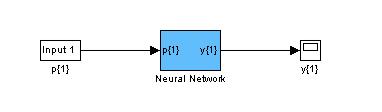

Структурна-схема розробленої мережі наведена на рис.6.5.

Рисунок 6.5 - Структурна-схема розробленої НМ

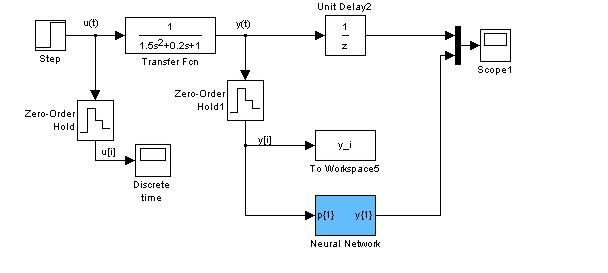

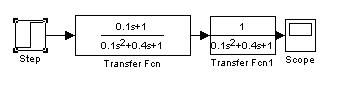

На наступному кроці копіюється структура НМ в базову модель рис.6.6.

Рисунок 6.6 – Імітаційна модель для перевірки роботи розробленої ШНМ

Результати роботи НМ на інтервалі 30с наведено на рис.6.7.

Рисунок 6.6 – Візуалізація результатів для порівняння роботи ШНМ (1) з виходом об'єкту (2)

За допомогою команд net.IW{1} та net.b{1} є можливість отримати значення синаптичних ваг та відповідних зсувів:

>> net.IW{1}

ans =

0.4034 0.3384

>> net.b{1}

ans =

0.2567

Зміна вищевказаних параметрів проводиться у наступному форматі:

>> net.IW{1}=[значення];

>> net.b{1} = [значення];

У фігурних дужках вказують номера шарів НМ. Так при наявності зв'язку другого шару (три нейрона) з першим (один нейрон) формат запису буде наступним:

>> net.LW{2,1}=[значення1; значення2; значення3];

для третього, вихідного шару з одним нейроном:

>> net.LW{3,2}=[значення1 значення2 значення3];

Варіанти завдань

Необхідно:

1) Отримати завдання згідно варіанту табл. 5.1.

Таблиця 6.1 – Варіанти завдань

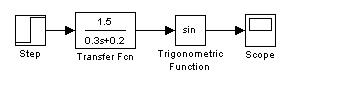

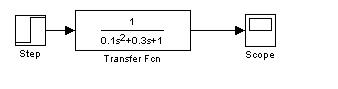

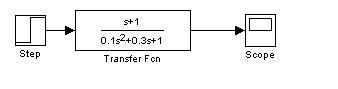

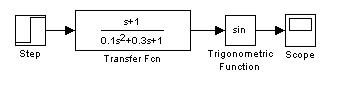

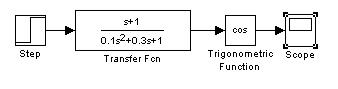

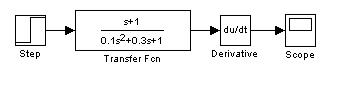

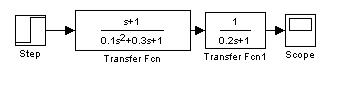

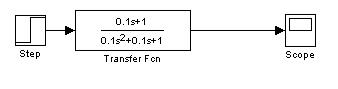

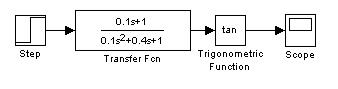

| # варіанту | Об'єкт | Час дискретизації | Час навчання/умова |

| 0,1 | 10с/

| |

| 0.2 | 10с/

| |

| 0,1 | 9с/

| |

| 0,05 | 10с/

| |

| 0,1 | 9с/

| |

| 0,1 | 10с/

| |

| 0,1 | 8с/

|

Продовження табл.6.1

| # варіанту | Об'єкт | Час дискретизації | Умови прогнозу |

| 0,01 | 10с/

| |

| 0,01 | 9с/

| |

| 0,05 | 7с/

| |

| 0,1 | 8с/

|

2) Провести параметричний та структурний синтез нейромережевої моделі об'єкту.

3) Перевірити ефективність роботи НМ на структурних моделях.

4) Розрахувати середньоквадратичну похибку роботи НМ.

5) Надати графічну ілюстрацію розробленої мережі з відповідними параметрами синаптичних зв'язків та зсувів.

6) Оформити детальний звіт.

Контрольні питання

1. Чи можна навчити нейронну мережу без прихованого шару?

2. У чому полягає навчання нейронних мереж?

3. Чому один з алгоритмів навчання отримав назву «Алгоритм зворотного розповсюдження»?

4. Чим відрізняється навчання з вчителем від навчання без вчителя?

5. Чому вхідні і вихідні сигнали нейронної мережі повинні бути нормовані, тобто приведені до діапазону [0,1]?

Індивідуальне домашнє завдання №3

Дата добавления: 2015-10-29; просмотров: 157 | Нарушение авторских прав

| <== предыдущая страница | | | следующая страница ==> |

| Нейромережеве прогнозування динамічного стану об'єктів керування | | | Графоаналітичне рішення задач електротехніки |