Читайте также:

|

В условиях отсутствия помех скорость передачи информации

определяется количеством информации, переносимым символом

сообщения в единицу времени, и соответственно равна:

C = n  H (9)

H (9)

Где n — количество символов, вырабатываемых источником

сообщений за единицу времени; H — энтропия (неопределённость),

снимаемая при получении одного символа сообщений, вырабатываемых

данным источником.

Скорость передачи информации также может быть представлена

следующим образом:

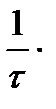

C =  бит/с (10)

бит/с (10)

Где τ — время передачи одного двоичного символа.

Скорость передачи информации всегда определяется относительно

первичного алфавита и зависит от его энтропии, а скорость передачи

сигналов вычисляется относительно вторичного алфавита (если аппаратура

обеспечивает передачу всех качественных признаков вторичного алфавита). Таким образом, скорость передачи информации зависит от информационных характеристик источника сообщений, а скорость передачи сигналов — от быстродействия аппаратуры. Величины эти не следует путать, так как они вычисляются по разным формулам и имеют разные единицы измерения. Так, в отличие от формулы (10), скорость передачи сигналов может быть вычислена по формуле:

V =  символ/с

символ/с

Где τ — время передачи одного символа вторичного алфавита.

Для сообщений, составленных из равновероятностных

взаимонезависимых символов равной длительности, скорость передачи

информации может быть определена следующим образом:

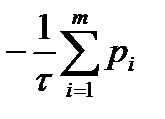

С =  log2 m бит/с (11)

log2 m бит/с (11)

В случае неравновероятностных символов равной длительности,

скорость передачи информации определяется согласно формуле:

C =

log2 pi бит/c (12)

log2 pi бит/c (12)

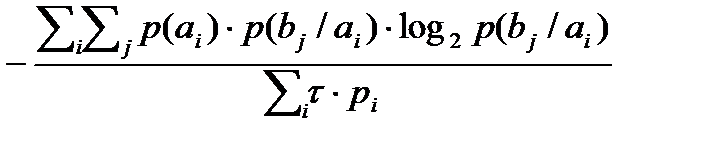

В случае неравновероятностных и взаимонезависимых символов

разной длительности, скорость передачи информации может быть

вычислена следующим образом:

С =  бит/с (13)

бит/с (13)

Где ai — передаваемый сигнал; bj — сигнал, соответствующий

переданному ai сигналу. События A и B статистически жёстко связаны. При отсутствии помех, условная вероятность максимальна p(bj / ai) = 1, а условная энтропия:

H(A/B) =  log2 p(bj / ai) = 0,

log2 p(bj / ai) = 0,

таккакlog2 p(bj / ai) = log21 = 0.

При высоком уровне помех любой из принятых сигналов bj можетсоответствовать любому переданному сигналу ai — статистическая связь между переданными и принятыми сигналами отсутствует. В этом случае вероятности p(ai) и p(bj) есть вероятности независимых событий и p(bj / ai) = p(bj); p(ai / bj) = p (ai).

Информационные характеристики реальных каналов лежат между этимидвумя предельными случаями.

Пропускная способность (или ёмкость канала связи) — есть

максимальная скорость передачи информации по данному каналу связи. Под каналом связи подразумевается совокупность средств, предназначенных для передачи информации от данного источника сообщений к адресату. Выражение для пропускной способности отличается от выражения (9) тем, что пропускную способность характеризует максимальная энтропия:

Сmax=  бит/с (14)

бит/с (14)

В случае для двоичного кода, выражение для расчёта пропускной

способности примет вид:

Cmax =  бит/с

бит/с

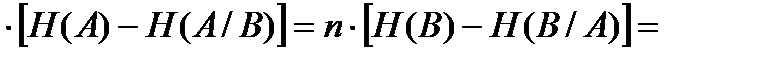

При наличии помех, пропускная способность канала связи вычисляетсякак произведение количества принятых в секунду знаков n на разность энтропии источника сообщений и условной энтропии источника сообщений относительно исходного сигнала:

Cn =n

бит/с (15)

бит/с (15)

или следующим образом:

Cn =  бит/с

бит/с

В общем случае:

Cn= n

=n  бит/с (16)

бит/с (16)

Если символы источника сообщений неравновероятны и

взаимозависимы, то энтропия источника вычисляется по формуле общей

условной энтропии.

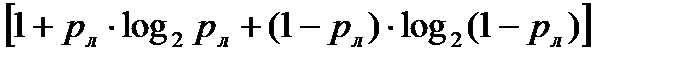

Для симметричных бинарных каналов, в которых сигналы передаются при помощи двух качественных признаков и вероятность ложного приёма pл = p(1/0) = p(0/1), а вероятность правильного приёма pп = 1 – pл, потери учитываются при помощи условной энтропии вида:

H(B/A)=

бит/c (17)

бит/c (17)

Пропускная способность для таких каналов может быть определена

следующим образом:

Cn = n

бит/с (18)

бит/с (18)

Таким образом, формула пропускной расчёта способности для

симметричного бинарного канала будет иметь следующий вид:

Cn =

бит/с (19)

бит/с (19)

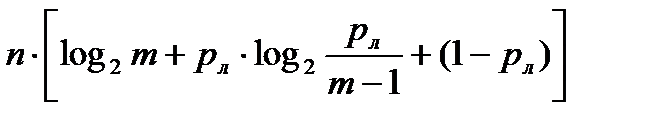

Для симметричных дискретных каналов связи с числом качественных

признаков m > 2, формула расчёта пропускной способности может быть

представлена в следующем виде:

Cn=  бит/c (20)

бит/c (20)

Дата добавления: 2015-08-10; просмотров: 59 | Нарушение авторских прав

| <== предыдущая страница | | | следующая страница ==> |

| Количественная оценка информации | | | Кодирование. |